深度解读:AI模型价格暴跌1000倍,为何你的支出不降反升?

type

status

date

slug

summary

tags

category

icon

password

网址

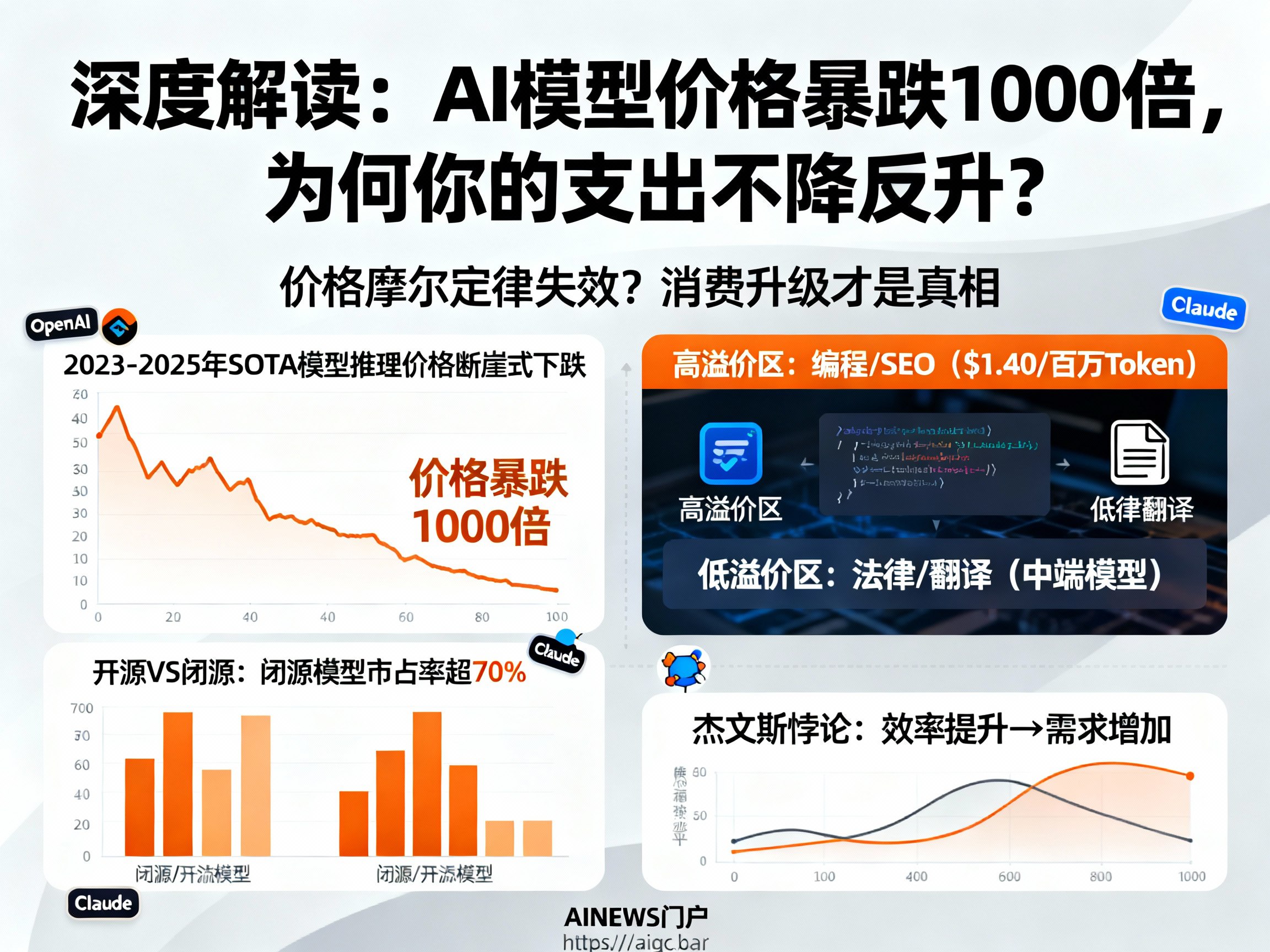

在人工智能飞速发展的今天,我们似乎正在经历一场前所未有的“算力通缩”。2025年末,波士顿大学Andrey Fradkin团队发布的一项重磅研究《智能的新兴市场:LLM的定价、供给与需求》,为我们揭示了一个反直觉的经济现象:虽然AI模型的推理价格在过去两年内下降了约1000倍,但企业和个人在AI上的实际支出成本却并没有随之降低。

这听起来像是一个悖论。按理说,技术成本的指数级下降应当带来廉价的普及,但数据却显示了另一种趋势。为了深入探究这一现象,我们需要结合全球主流LLM聚合平台的数据,剖析大模型(LLM)市场的微观经济学逻辑。如果您关注最新的 AI资讯 和 AGI 发展趋势,欢迎访问 AINEWS门户 获取更多深度分析。

“价格摩尔定律”失效?消费升级才是真相

数据显示,从2023年到2025年,SOTA(最先进)级别模型的推理价格经历了断崖式下跌。然而,用户平均支付的每Token单价却保持了惊人的稳定。这打破了“AI将迅速廉价化”的简单线性预测。

究其原因,这是一场典型的“消费升级”。虽然旧技术(如GPT-3.5级别的能力)的成本几乎归零,但市场对“更高智能”的需求弹性极大。用户并没有因为基础模型变得免费而停留在原地,相反,他们将节省下来的预算,全部投入到了更昂贵、更聪明的新一代 大模型 中。这不是一场逐底竞争(Race to the Bottom),而是用户在不断追求更高质量的 Prompt 响应和更复杂的推理能力。

开源与闭源的博弈:90%的价格鸿沟为何无法逾越?

在同等智力水平下,开源模型的价格平均比闭源模型低90%。按常理推断,如此巨大的价格优势应该让开源模型横扫市场。但现实数据却狠狠打脸:闭源模型始终占据主导地位,开源模型的市场份额长期徘徊在30%以下。

这揭示了 人工智能 市场的非价格壁垒依然坚固。对于企业而言,闭源模型往往意味着更稳定的服务、更完善的API支持以及更低的部署维护成本。单纯的价格优势不足以弥补技术整合的隐性成本。这也提醒了关注 AI变现 的开发者,单纯靠低价策略很难在高端市场立足,构建生态和服务壁垒才是关键。

场景分化:为何编程昂贵,翻译廉价?

AI 并不是一种标准化的商品,它在不同场景下的“支付意愿”天差地别。研究绘制的“AI价值热力图”揭示了深刻的行业洞察:

- 高溢价区:SEO和编程。用户愿意为这些场景支付高达$1.40/百万Token的费用。原因很简单,代码的准确性直接关系到生产力,一个错误的字符可能导致系统崩溃,因此用户对高质量模型的付费意愿极强。

- 低溢价区:法律和翻译。在这些任务中,中端模型已足够胜任,用户不愿为此支付溢价。

这意味着通用大模型在商业落地时,将面临严峻的垂直差异化挑战。未来的利润高地,将集中在那些“稍微聪明一点就能创造巨大价值”的领域。

杰文斯悖论的现代演绎:需求与供给的动态平衡

经济学中著名的“杰文斯悖论”指出:技术的进步提高了资源利用效率,反而会增加(而非减少)对该资源的消耗。在 LLM 领域,我们正见证这一悖论的重演。

短期内,需求的价格弹性略高于1,意味着降价确实带来了使用量的超额增长。当 Claude 或 OpenAI 发布新一代模型时,我们看到了两种截然不同的竞争模式:一种是同室操戈,新模型完全替代旧模型;另一种是市场扩张,高性价比模型开发出了全新的应用场景。

对于企业而言,虽然数据显示超过50%的企业会尝试多个模型,但绝大多数企业最终将90%以上的Token消耗集中在单一模型上。这说明企业在寻找最适合自己的那一个模型后,会形成较强的路径依赖。

结语

AI市场的格局远未固化。这既不是一个赢家通吃的垄断市场,也不是一个完全同质化的红海。无论是深耕高溢价的复杂推理,还是通过高性价比拓宽市场边界,在这个快速膨胀的宇宙中,每一个生态位都蕴藏着巨大的机会。

对于关注 AI新闻 和行业动态的从业者来说,理解这种“降价不降本”背后的逻辑至关重要。它告诉我们,未来的竞争核心不在于谁更便宜,而在于谁能提供更不可替代的智能价值。

想要了解更多关于 chatGPT、Claude 以及全球 人工智能 的最新动态和 AI日报,请持续关注 AINEWS,我们将为您带来最前沿的行业洞察。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)