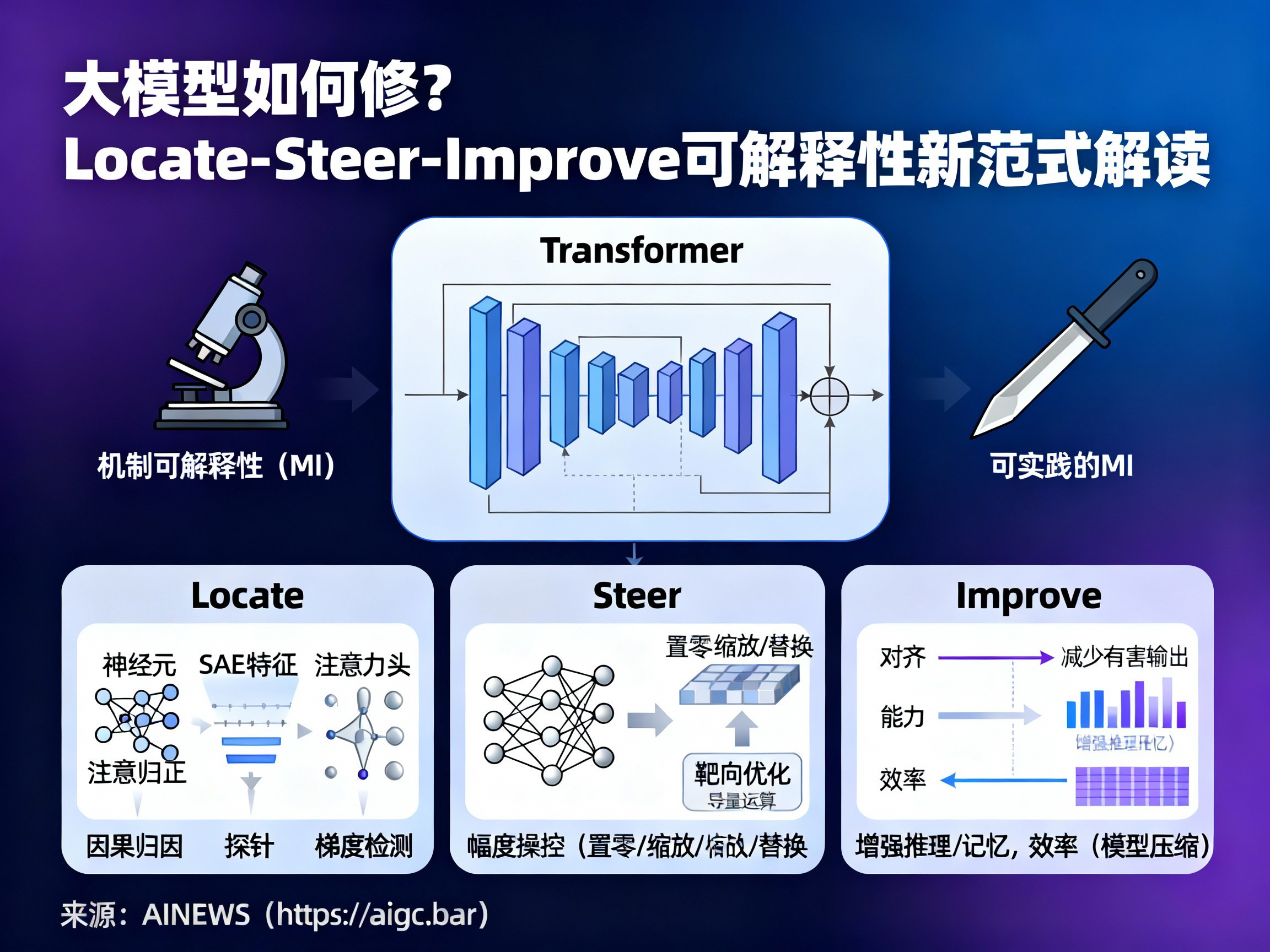

大模型如何修?Locate-Steer-Improve可解释性新范式解读

type

status

date

slug

summary

tags

category

icon

password

网址

在人工智能飞速发展的今天,大语言模型(LLM)已经展现出了惊人的能力,但长期以来,它们在很大程度上仍被视为一个难以捉摸的“黑盒”。我们知道输入什么会得到输出,却往往难以解释模型内部究竟发生了什么。过去几年,机制可解释性(Mechanistic Interpretability, MI)的研究让科学家们得以窥探这一黑盒的内部,追踪信息在Transformer架构中的流动。

然而,仅仅“看见”是不够的。对于开发者和研究人员而言,更迫切的需求不仅是理解“模型为什么这么回答”,而是如何让模型“更稳、更准、更安全”。近期,来自香港大学、复旦大学等顶尖机构的研究团队联合发布了一篇重磅综述《Locate, Steer, and Improve》,提出了一套从“显微镜”向“手术刀”转变的全新方法论。本文将结合AINEWS的最新资讯,深入解读这一“Locate-Steer-Improve”三阶段范式,探讨大模型如何实现从不可解释到可控可修的跨越。

从“显微镜”到“手术刀”:范式的根本转移

传统的机制可解释性研究,更多停留在“观察”层面。研究者们试图搞清楚哪些神经元对应了特定的实体,或者哪些注意力头(Attention Heads)负责处理语法结构。这种研究类似于使用“显微镜”,虽然能看清细胞结构,却无法直接治疗疾病。

最新的研究趋势则致力于将MI转化为“手术刀”。这意味着我们不仅要发现模型内部的机制,更要利用这些发现来直接干预模型的行为。这篇综述的核心贡献在于,它系统地梳理了如何将解释性发现转化为实际的模型改进,即“可实践的机制可解释性”(Actionable Mechanistic Interpretability)。这对于追求AGI(通用人工智能)过程中的模型对齐和安全性至关重要。

第一阶段:Locate——像医生一样精准定位“病灶”

任何有效的干预都始于准确的诊断。在“Locate”阶段,目标是在庞大的神经网络参数中,找到影响特定行为的关键组件。

这一阶段的工作可以分为微观和宏观两个层面。在微观层面,研究对象从传统的单个神经元(Neuron)进化到了更为精细的稀疏自编码器特征(SAE Feature),这使得我们能更解耦地理解模型的特征表示。在宏观层面,研究者关注注意力头和残差流(Residual Stream)等组件的信息传递。

为了实现精准定位,研究人员开发了多种“诊断工具”,包括:

* 因果归因(Causal Attribution):分析特定组件对最终输出的因果贡献。

* 探针(Probing):通过训练简单的分类器来检测内部状态中是否包含特定信息。

* 梯度检测(Gradient Detection):利用梯度信息追踪错误来源。

通过这些手段,我们能够像外科医生定位肿瘤一样,精确找到导致模型产生幻觉或有害输出的具体“病灶”。

第二阶段:Steer——面向干预的“手术”手段

当关键对象被定位后,下一步就是进行干预,即“Steer”阶段。这是机制可解释性走向实践的关键一步,主要包含三种手段:

- 幅度操控(Amplitude Manipulation):这是一种简单直接的方法,包括将特定神经元的激活值置零(ablation)、缩放(scaling)或替换(patching)。这就像是调节电路中的电阻,通过物理层面的“开关”或“强度”调节来控制模型行为。

- 靶向优化(Targeted Optimization):利用定位到的关键组件进行参数级的微调。与全量微调不同,这种方法仅针对特定的Attention Heads或层进行调整,效率更高且副作用更小,能有效避免“灾难性遗忘”。

- 向量运算(Vector Arithmetic):在激活空间中直接加入或移除代表特定任务或特征的向量。例如,通过在推理过程中注入“诚实”向量,引导模型生成更真实的回答。

这些手段赋予了开发者在不重新训练整个模型的情况下,修正模型行为的能力。

第三阶段:Improve——在对齐、能力与效率上的全面进化

所有的定位和操控,最终目的都是为了提升模型性能。在“Improve”阶段,MI的应用主要体现在三个核心场景:

- 对齐(Alignment):这是AI安全领域最关注的问题。通过定位与有约束的干预,可以有效减少模型的有害行为,降低幻觉(Hallucination),并提升模型遵循指令的稳定性。例如,通过抑制负责产生偏见内容的神经元,可以让模型更加公正。

- 能力(Capability):将机理层面的发现转化为具体的能力增强。研究表明,通过优化特定的推理电路,可以显著提升模型的逻辑推理能力、记忆能力以及语言生成的质量。

- 效率(Efficiency):机制可解释性还为模型压缩提供了新思路。通过识别并剪枝那些对模型性能贡献微弱的组件,可以实现更高效的训练和推理,从而降低部署成本。

展望未来:迈向自动化的AI修复

这篇综述不仅总结了当下的技术,更指明了未来的方向。目前,机制可解释性面临的最大挑战是“各自为战”,缺乏标准化的评估基准。未来,我们需要建立统一的标准来验证干预手段的泛化性。

更令人兴奋的前景是自动化MI(Automated MI)。随着技术的发展,我们有望构建出能够自主发现内部错误并进行自我修复的AI系统。这将是通往真正可信、可控AGI的重要里程碑。

了解更多关于人工智能、大模型(LLM)及AI资讯的最新动态,请持续关注 AINEWS。无论是OpenAI的ChatGPT更新,还是Claude等前沿模型的进展,掌握底层机制的原理,都将帮助我们更好地利用这一波AI浪潮。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)