AI性能真的超越人类了吗?深度解析人类基准测试的“翻车”真相与大模型评估陷阱

type

status

date

slug

summary

tags

category

icon

password

网址

引言:AI“超人类”结论背后的信任危机

在人工智能(AI)飞速发展的今天,我们几乎每天都能看到“某大模型在某项测试中表现超越人类”的报道。无论是在自然语言理解、逻辑推理还是复杂编程任务中,AI似乎正在全面接管人类的智力高地。然而,这些所谓的“超人类”结论真的经得起推敲吗?

近期,来自美国哈佛大学的研究员魏来(Kevin Wei)及其合作者的一项研究引发了学术界和工业界的震动。该研究指出,当前用于衡量AI性能的“人类基准测试”(Human Baselines)在严谨性和透明度上存在严重缺陷。相关论文《立场:模型评估中的人类基线需要严谨性和透明性》已发表于机器学习顶级会议 ICML 2025。本文将深入探讨这项研究的核心观点,并分析为何我们需要重新审视当前的AI性能评估体系。

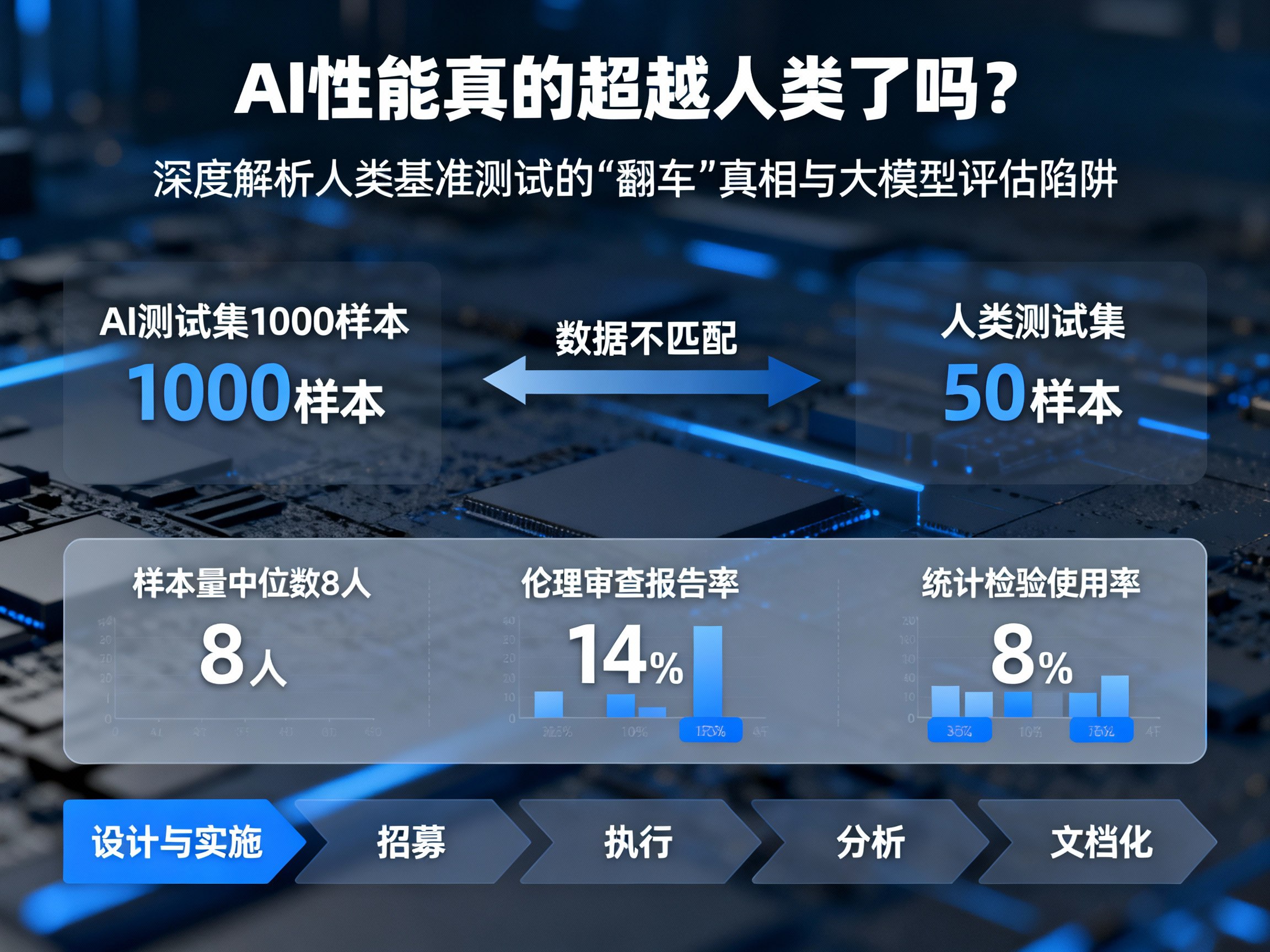

数据不匹配:一场“不公平”的竞赛

研究发现,目前许多AI评估实验中,AI和人类参与者面对的并不是同一个“竞技场”。在系统回顾的115项人类基线研究中,竟然只有 59% 的基线测试使用了与AI完全相同的测试集。

这种差异化测试直接导致了结论的偏差。例如,在某些实验中,研究人员可能会给AI系统提供1000个样本进行测试,但为了节省成本或时间,仅从中抽取50个样本让参与测试的人类来完成。随后,研究者将这50个人的平均表现与AI在1000个样本上的表现进行对比。这种样本选择的不对称性,使得所谓的“AI胜过人类”的结论在统计学上显得苍白无力。

样本量严重不足:8个人的结论能代表人类吗?

在科学研究中,样本量是确保结论具有普适性的基础。然而,在AI模型评估领域,人类基线的样本量普遍偏低。

魏来的研究显示,以单个测试题目计算,人类回应者的人数中位数竟然只有 8人。在如此小的样本量下,个体的偶然表现会极大地影响最终结果,根本无法代表更广泛人群的真实水平。这种“以偏概全”的做法,不仅降低了评估的可信度,也让AI与人类的层级比较变得毫无意义。如果基准线本身就是不稳定的,那么基于此得出的“超人类”结论自然也站不住脚。

透明度缺失:被忽视的伦理与统计严谨性

除了样本设计的问题,研究过程的不透明也是一大隐患。研究指出,仅有 14% 的论文报告了伦理审查情况,绝大多数研究并未公开其测试方法、参与者背景信息以及数据分析代码。

更令人担忧的是,在统计检验的使用上,仅有 8% 的基线研究进行了必要的统计检验。在缺乏统计显著性分析的情况下,AI表现出的微弱优势可能仅仅是随机误差的结果。这种信息不对称和流程不透明,不仅阻碍了研究的可重复性,更可能掩盖了实验过程中的潜在偏差。

五阶段改进框架:构建可靠的AI评估体系

针对上述问题,魏来团队提出了一个全新的框架,旨在通过五个关键阶段提升人类基准测试的科学性:

- 设计与实施:确保测试集的一致性与代表性,收集足够规模的样本。

- 招募:明确目标人群,采用科学的抽样策略和质量控制。

- 执行:控制人类与AI的投入程度,收集定性的解释数据以增强说服力。

- 分析:量化表现之间的不确定性,确保评分标准和指标的统一。

- 文档化:全面报告方法论细节,遵循开放科学标准。

这一框架不仅借鉴了心理学、经济学等跨学科知识,更为未来大模型(LLM)在数学、医疗等高精尖领域的评估指明了方向。

结论:理性看待AI进步,呼吁行业标准

AI是否真的能替代人类工作,不仅是一个技术问题,更是一个严肃的社会和经济问题。如果我们依赖于不严谨、不透明的基准测试来制定政策或进行商业决策,其后果可能是灾难性的。

魏来的这项研究为狂热的AI竞赛泼了一盆冷水,也为我们提供了一个理性的视角:AI的进步需要被证明,而这种证明必须建立在严谨、透明且公平的科学基础之上。

作为关注AI前沿动态的读者,我们需要学会辨别那些夸大其词的宣传,转向更具科学性的资讯来源。想要获取更多关于AI、大模型、Prompt工程以及AGI的深度资讯和行业日报,欢迎访问 https://aigc.bar,掌握真实、前沿的人工智能动态。只有建立在真实性能评估基础上的AI发展,才能真正推动社会的进步。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)