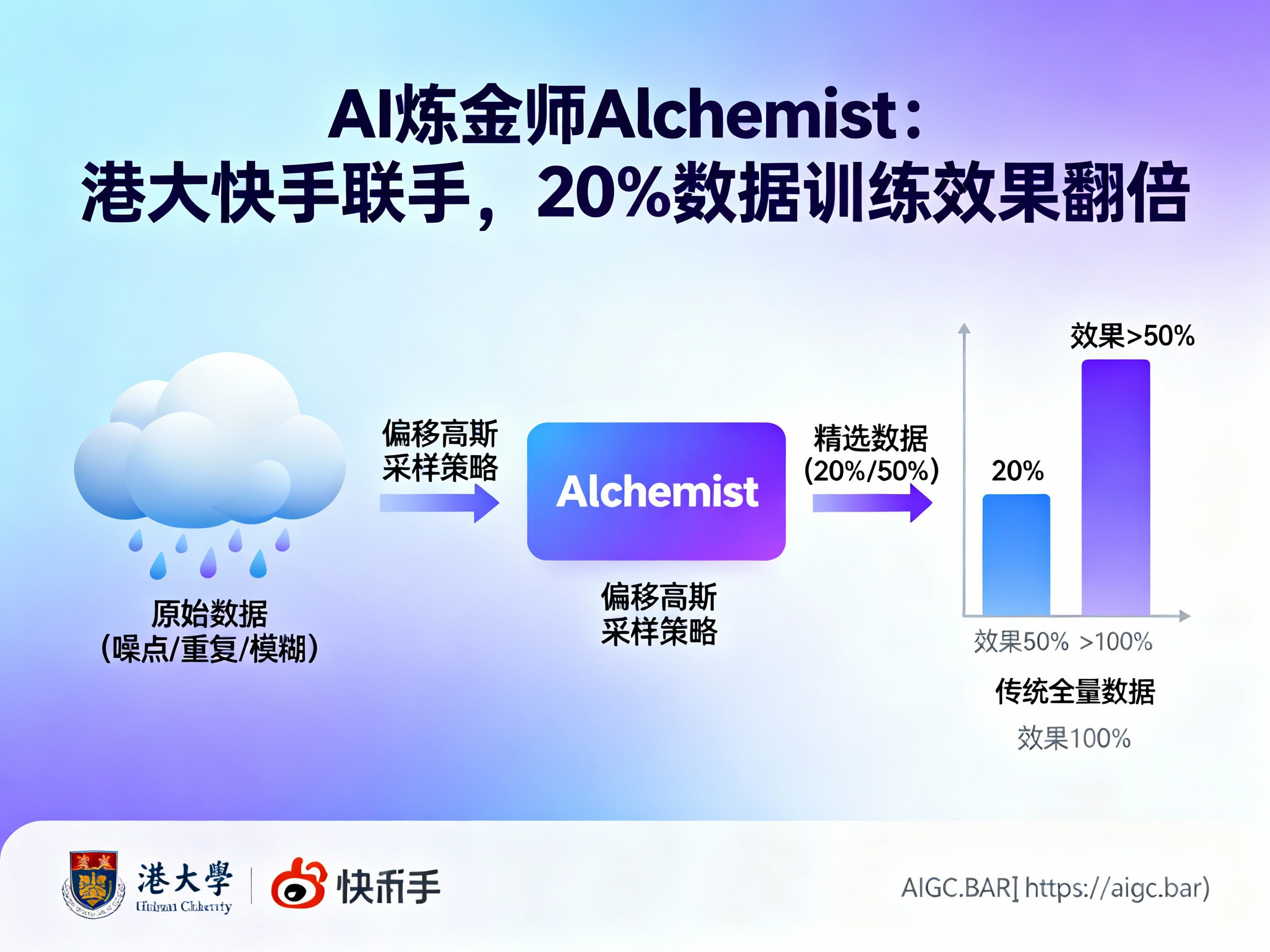

AI炼金师Alchemist:港大快手联手,20%数据训练效果翻倍

type

status

date

slug

summary

tags

category

icon

password

网址

在人工智能飞速发展的今天,大模型(LLM)和图像生成模型的训练往往被视为一场“算力与数据的暴力美学”。然而,随着网络爬取数据量的爆炸式增长,一个核心问题逐渐浮出水面:更多的数据真的等于更好的效果吗?答案是否定的。正如大厨无法用腐烂的食材烹饪出米其林级别的佳肴,AI模型的性能同样受限于训练数据的质量。

近期,香港大学联合快手科技团队推出了一项名为“炼金师”(Alchemist)的突破性研究。这项技术不仅打破了“数据越多越好”的迷思,更通过精准的数据筛选机制,实现了用20%的数据达到50%的效果,甚至用50%的精选数据超越了全量数据的训练表现。对于关注AGI和人工智能发展的从业者来说,这无疑是指明了未来高效训练的新方向。想获取更多前沿AI资讯,欢迎访问 AIGC.BAR。

数据饥渴时代的“挑食”智慧

目前的AI图像生成模型(如Stable Diffusion、FLUX等)通常依赖于从互联网上抓取的数百万甚至数十亿张图片进行预训练。然而,这些原始数据往往充斥着噪点、重复内容、模糊不清的图像甚至是毫无意义的广告背景。传统的训练方式就像是把所有食材一股脑扔进锅里,导致模型“消化不良”,不仅浪费了宝贵的算力资源,还可能引入错误的归纳偏置。

“炼金师”Alchemist系统的核心理念在于让AI学会“挑食”。它不再盲目吞噬所有数据,而是像一位经验丰富的美食评委,从海量数据中筛选出真正“有营养”的部分。研究团队发现,通过这种智能筛选,仅使用20%的精选数据,就能达到随机使用50%数据所能达到的训练效果;而当使用50%的精选数据时,模型的最终性能甚至超过了使用100%全量数据。这意味着,我们过去在训练大模型时,可能有超过一半的算力和时间都被浪费在了处理无效数据上。

核心技术揭秘:偏移高斯采样策略

传统的AI数据筛选方法(如Top-K策略)往往存在一个误区:它们倾向于选择评分最高的数据。然而,评分最高的图片通常是背景纯白、构图极其简单的产品图。这些图片虽然清晰,但对于提升模型的泛化能力和理解复杂场景的能力帮助甚微。这就好比学生只做最简单的加法题,虽然正确率高,但数学能力永远无法提升。

Alchemist引入了创新的“偏移高斯采样”(Shift-Gsample)策略。这一策略基于一个反直觉的发现:最有价值的数据往往不是那些评分最高的“简单样本”,而是处于评分中上游(30%-80%区间)的“中等难度样本”。

- 避开简单陷阱:系统会刻意避开那些一眼就能看穿的简单图片(0-20%高分区域),因为它们提供的信息量太少。

- 锁定黄金区间:重点挖掘内容丰富、主题明确且具有一定视觉挑战性的图片。这些数据就像是“营养均衡的正餐”,能有效促进模型的深度学习。

- 保持多样性:系统还会保留少量的简单和困难样本,以维持数据分布的多样性,防止模型过拟合。

这种策略就像是为AI制定了一套科学的健身计划,既不安排无效的轻松运动,也不强行进行会导致受伤的极限挑战,而是专注于最能长肌肉的“黄金训练区”。

AI如何学会“自我评判”

Alchemist之所以被称为“炼金师”,是因为它具备了自我反思和评判的能力。它不仅仅是根据预设规则过滤数据,而是通过一个双层优化框架(Bi-level Optimization)来动态调整评分标准。

在该框架下,Alchemist训练了一个专门的评分员模型。这个评分员会实时监控目标模型(Student Model)的学习状态。它的评判标准非常务实:

- 有效性验证:如果一张图片被模型学习后,能够显著降低验证集上的损失(Loss),说明这张图片让模型“学到了东西”,因此会被标记为好数据。

- 无效剔除:如果模型在某张图片上花费了大量计算资源,但验证性能没有提升,这张图片就会被判定为无用数据或噪声。

通过这种元梯度(Meta-gradient)更新机制,Alchemist能够像一位严厉的导师,通过观察学生的考试成绩(验证集性能)来不断调整教学大纲(数据权重),确保每一份投入的算力都能转化为模型能力的实质提升。

实验数据:少即是多的胜利

在LAION-30M等大规模数据集上的实验结果令人振奋。Alchemist不仅在训练速度上实现了最高5倍的提升,更在跨模型和跨数据集的适应性上表现出色。

- 训练提速:由于剔除了大量无效数据,模型收敛速度大幅加快,且训练过程中的波动更小,性能提升更加稳健。

- 跨域通用:无论是网络爬取的真实数据,还是AI生成的合成数据,亦或是包含人类偏好的数据集,Alchemist都能精准识别出其中的高价值样本。

- 小模型撬动大模型:研究还表明,可以使用较小的代理模型(如0.3B参数)来筛选数据,然后将筛选出的优质数据用于训练更大的模型(如0.9B参数),且效果依然显著。这大大降低了数据清洗的成本。

结语与展望

“炼金师”Alchemist的出现,标志着人工智能训练正在从“以量取胜”向“以质取胜”转变。在大模型参数量不断膨胀、算力成本居高不下的背景下,这种数据侧的优化显得尤为珍贵。它不仅为企业节省了巨额的训练成本,也为AGI的实现提供了一条更加高效、环保的路径。

未来,随着类似技术的普及,我们或许不再需要盲目追求万亿级的数据规模,而是将更多精力投入到如何定义和筛选“高营养”数据上。在这个数据为王的时代,谁掌握了高效的数据炼金术,谁就掌握了通往AI未来的钥匙。

更多关于人工智能、LLM及AI新闻的深度解读,请持续关注 AIGC.BAR,获取最新的行业动态与技术干货。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)