打破代码模型盲盒:北航新Scaling Law揭示多语言最优配比与Python统治力

type

status

date

slug

summary

tags

category

icon

password

网址

引言

在人工智能飞速发展的今天,代码大模型(Code LLMs)已经成为辅助编程、软件开发自动化不可或缺的工具。长期以来,行业内普遍存在一种简单粗暴的“大力出奇迹”思维:认为只要堆叠足够多的代码数据,模型性能就会线性增长。这种惯性思维将所有编程语言视为同质化的文本数据,忽略了Python、Java、Rust等语言在语法特性、逻辑结构和语料规模上的巨大差异。

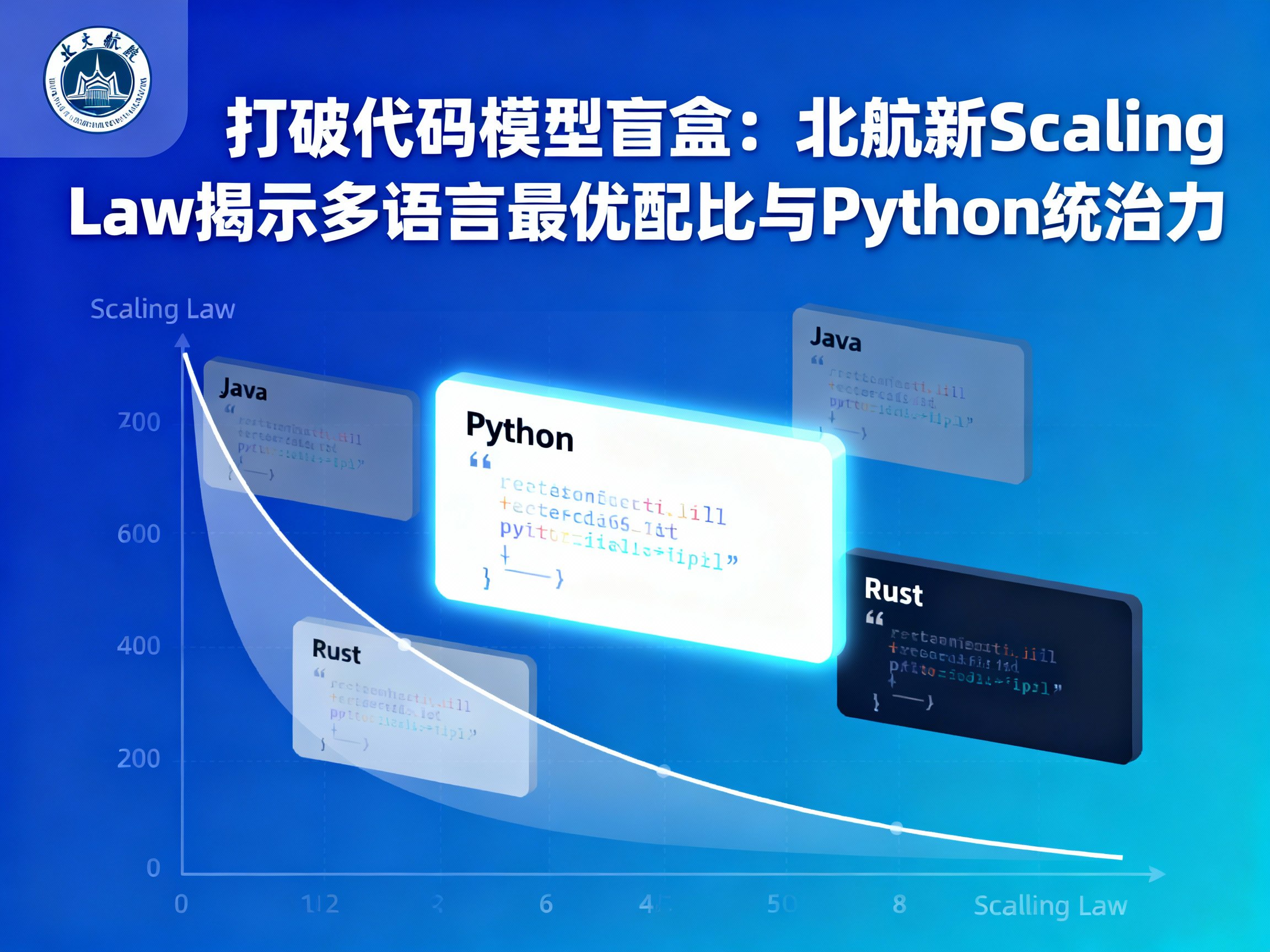

然而,现代软件工程本质上是多语言协作的复杂系统。如果忽略语言间的差异,盲目应用通用的Scaling Laws(缩放定律),不仅会导致模型性能预测出现偏差,更会造成宝贵算力的巨大浪费。近期,北航研究团队的一项突破性工作——《Scaling Laws for Code: Every Programming Language Matters》,通过超过1000次实验,打破了这一黑盒,为我们揭示了代码大模型训练背后的深刻规律。本文将深入解读这项研究,探讨如何通过科学的数据配比策略,构建更强大的 LLM 和 大模型 基座。

语言特异性:为何Python是王者,而Rust早早“躺平”?

这项研究最核心的发现之一,就是彻底否定了“所有代码生而平等”的假设。研究团队在耗费了相当于33.6万个H800 GPU时的算力后,绘制出了不同编程语言各自独立的Scaling Law曲线。

结果令人惊讶:Python 展现出了极高的训练潜力。随着模型参数规模和数据量的增加,Python的Loss(损失函数)下降曲线最为陡峭,这意味着投入更多的算力在Python数据上,能获得持续且显著的性能回报。相比之下,Rust 语言的曲线则表现出快速收敛的特征,它更早地趋于平缓。这并不意味着Rust不重要,而是说明其语法严谨性可能导致了信息密度的不同,模型能更快地“学会”其核心模式,继续盲目堆砌Rust数据带来的边际效益会迅速递减。

这一发现对于 AI 开发者至关重要:在资源有限的情况下,应优先保证高潜力语言(如Python)的“喂养”,而对快速收敛的语言(如Rust)则可以适度“节食”,从而避免算力浪费。

协同效应矩阵:Java的“吸星大法”与Python的“无私奉献”

在实际的 人工智能 模型预训练中,我们几乎总是混合多种语言。那么,这种“大杂烩”究竟是互相干扰,还是互相促进?北航团队构建的“协同增益矩阵”给出了量化答案。

实验表明,绝大多数语言都能从多语言混合训练中获益,这种现象被称为“协同效应”(Synergy)。其中,Java 成为了多语言训练的最大受益者。无论与哪种语言混合,Java的Loss都能大幅降低。这可能是因为Java作为成熟的面向对象语言,其严谨的结构能从其他语言的范式中汲取通用逻辑,仿佛练就了“吸星大法”。

与之形成鲜明对比的是 Python。作为代码领域的通用“供体”,Python极大地帮助了其他语言提升性能,但它自身从其他语言获得的收益却相对有限,甚至在某些混合比例下会出现轻微的“负迁移”。这一非对称的互助关系提示我们,在构建 大模型 语料库时,不能简单地随机混合,而需要精细设计策略,以平衡这种不对等的贡献与收益。

跨语言对齐:并行配对激发的Zero-Shot潜能

除了单语言生成,跨语言翻译(如将Java代码重构为Python)也是衡量模型能力的重要指标。传统的训练方法往往是将数据随机打乱(Random Shuffling),但这切断了不同语言版本代码之间的逻辑联系。

研究提出了一种更为高效的策略——并行配对(Parallel Pairing)。这种方法利用了 LLM 的长上下文窗口,将一段代码与其翻译版本拼接在同一个Context中输入模型。这相当于为模型提供了隐式的“双语对照读物”。

结果显示,并行配对策略不仅显著降低了Loss,更激发了惊人的 Zero-Shot(零样本) 泛化能力。例如,模型即使只学习了“Python↔Java”和“Python↔Go”的配对,也能在从未见过的“Java↔Go”翻译任务中表现出色。这证明了以Python为枢纽构建平行语料,可以有效拉齐不同编程语言的向量空间,极大地提升了 AGI 在代码理解层面的通用性。

基于经济学的最优Token分配指南

基于上述发现,论文提出了“科学配比的多语言 Scaling Law”。这不是一个枯燥的数学公式,而是一套指导算力投资的实战指南,其核心原则是:边际效用最大化。

在总算力固定的约束下,传统的均匀分配(每种语言数据量一样)并非最优解。根据不同语言的学习曲线斜率,我们应该动态调整数据配比。

- 增加投入:对于Python这样潜力大、斜率陡峭的语言,应大幅增加其Token占比,因为每一份投入都能带来可观的性能提升。

- 适度削减:对于Rust、Go等快速饱和的语言,应适当削减其占比,将节省下来的算力转移给高潜力语言。

实验验证显示,采用这种“引导式分配”策略训练出的1.5B模型,在多语言代码生成和翻译任务上,均稳定优于均匀分配的基线模型。这为 AI变现 和企业级模型训练提供了极具价值的成本优化方案。

结论

北航的这项研究是代码大模型领域的一次重要“去魅”。它用详实的数据证明,编程语言在模型训练视角下绝非同质。对于致力于 AI资讯 关注者和模型训练者而言,这意味着数据工程的重点应从单纯的“清洗与去重”转向更宏观的“成分配比”。

理解不同语言的Scaling特性以及它们之间的协同关系,能够帮助我们在有限的算力预算下,训练出综合代码能力更强的基座模型。这不仅是算法的优化,更是资源配置效率的提升。随着 人工智能 技术的不断深入,这种精细化的Scaling Law研究将成为构建下一代高效 大模型 的基石。

想要了解更多关于 AI新闻、大模型 前沿技术以及 ChatGPT、Claude 等工具的最新动态,请持续关注 AIGC.BAR。我们将为您提供最及时、最深度的行业洞察。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)