阿里RTPurbo重塑长文本:Qwen3推理5倍压缩与AI资讯深度解析

type

status

date

slug

summary

tags

category

icon

password

网址

在当今的 AI资讯 和 大模型 领域,一个看似矛盾的现象正困扰着开发者与产品经理:虽然模型厂商竞相宣称支持 128K 甚至更长的上下文窗口,但在实际应用中,长文本的高昂计费和高延迟却让“超长上下文”成为了奢侈品。为什么 Claude 能读完整本书,但普通应用却不敢轻易尝试?答案在于传统的 Full Attention(全量注意力)机制——随着输入长度的增加,计算开销呈平方级增长。

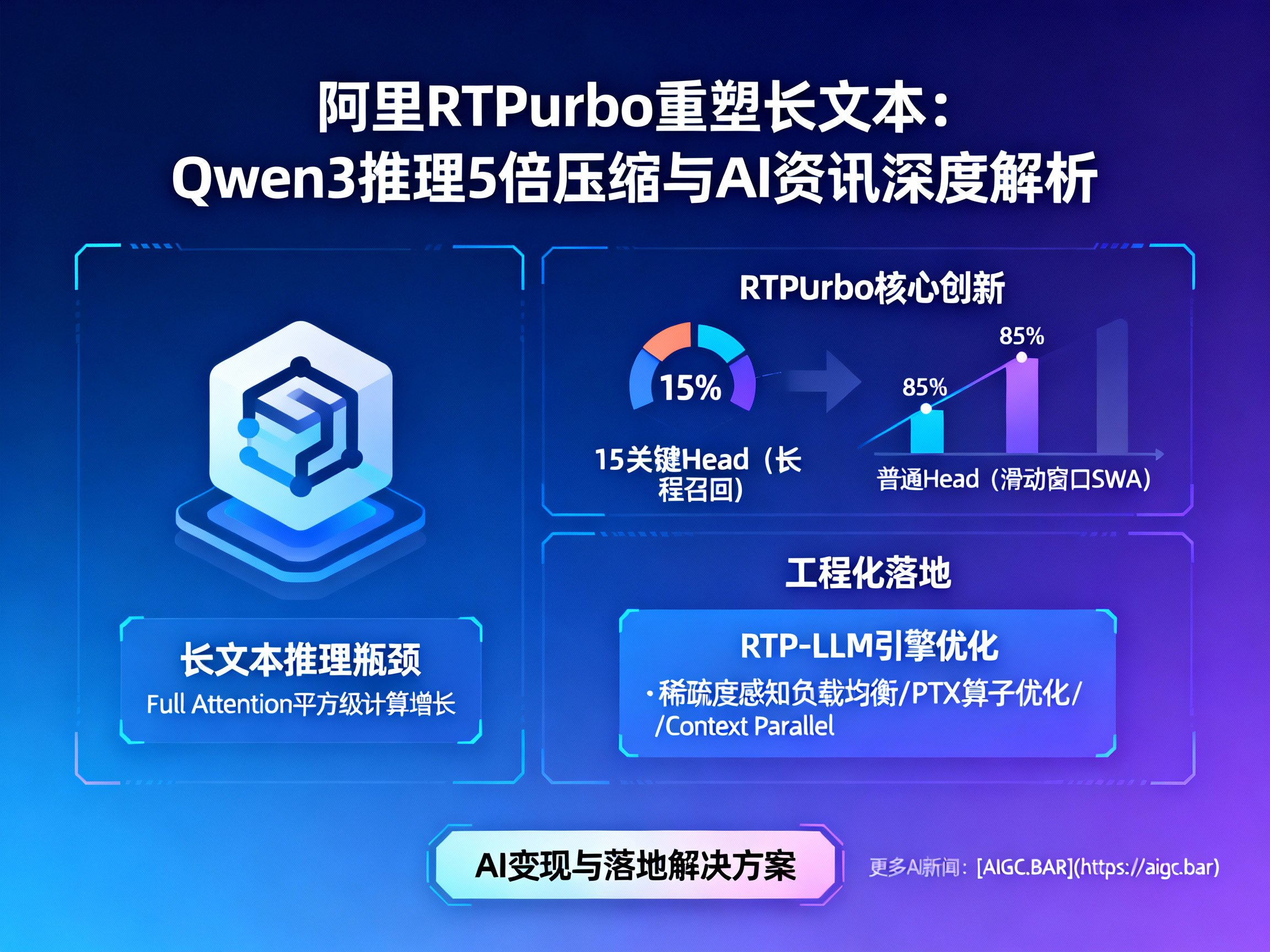

针对这一核心痛点,阿里 RTP-LLM 团队近期推出了一项突破性技术:RTPurbo。这项技术在阿里 Qwen3 等模型上验证成功,通过一种全新的后训练压缩方案,在不损失模型核心效果的前提下,实现了 Attention 计算的 5 倍压缩。这不仅是 LLM 架构演进的重要一步,更为 AI变现 和落地提供了极具性价比的解决方案。如果您关注更多前沿 AI新闻,请访问 AIGC.BAR 获取最新动态。

突破瓶颈:为何长文本推理如此昂贵?

在深入 RTPurbo 之前,我们需要理解 大模型 处理长序列的根本难题。主流 LLM 依赖 Full Attention 机制,这意味着模型在生成每一个 token 时,都要回头去“看”之前所有的 token。这种机制虽然保证了信息的完整性,但当序列长度达到数万甚至数十万时,计算量和显存占用会爆炸式增长。

这就是为什么许多 人工智能 产品在落地时,不得不通过截断用户输入或使用 RAG(检索增强生成)来规避长上下文推理。然而,RTPurbo 的出现打破了这一僵局。它证明了我们并不需要时刻关注“所有”信息,通过智能地分配注意力,可以将计算资源集中在最关键的地方。

核心创新:Headwise 混合压缩策略

RTPurbo 的核心理念源于对 LLM 内部机制的深刻洞察:并非所有的 Attention Head(注意力头)都生而平等。

研究团队发现,大模型处理信息的方式与人类阅读惊人地相似。在阅读长文时,我们通常会先通过少量的“关键线索”在长文中定位相关段落(召回),然后在局部范围内进行精细阅读(推理)。

基于此,RTPurbo 采用了一种非侵入式的 Headwise 混合压缩方案:

- 15% 的关键 Head:保留 Full Attention。这些 Head 承担着“长程信息召回”的重任,确保模型不会在长文中迷失方向,能够捕捉到远距离的关键依赖。

- 85% 的普通 Head:采用滑动窗口注意力(Sliding Window Attention, SWA)。这些 Head 专注于局部上下文,处理高信噪比的近期信息,直接丢弃冗余的远程 token。

这种设计使得 Qwen3 等模型在仅使用 15% 全量 Attention 的情况下,依然保持了强大的长文本理解能力,极大地降低了推理代价。

自蒸馏训练:解决压缩后的“水土不服”

虽然直接切换 Attention 模式能带来理论上的加速,但在实际操作中,未经微调的压缩模型往往会出现性能退化。这是因为模型习惯了全量信息,突然的模式切换会造成输出扰动。

为了解决这一问题,同时避免 大模型 训练中常见的灾难性遗忘,RTPurbo 引入了“模型自蒸馏”策略。这是一种极其高效的 AGI 训练范式:

- 无需昂贵标注数据:不依赖大量人工标注的长文数据。

- Teacher-Student 模式:让压缩后的模型(学生)去模仿原模型(老师)的输出分布。

- 快速收敛:实测显示,仅需约 1 万条预训练语料和小时级的训练时间,就能让模型在长文任务上的表现恢复到与原模型持平,同时保留了对话、代码理解等通用能力。

RTP-LLM 引擎:工程化落地的最后一块拼图

算法的创新需要强大的工程底座来支撑。RTPurbo 的方案虽然精妙,但混合了 Full Attention 和 SWA 带来了计算负载不均衡的问题。如果处理不好,GPU 的并行效率会大打折扣。

阿里 RTP-LLM 引擎为此进行了深度的底层优化:

- 稀疏度感知的负载均衡:动态调度计算任务,避免某些计算单元空转,降低尾延迟。

- PTX 级算子优化:深入指令层,利用异步拷贝和矩阵乘指令提升 Full Head 的计算效率。

- Context Parallel (CP):在大规模长序列场景下,采用 CP 替代传统的 Tensor Parallel (TP),显著提高了 GPU 的利用率。

这些优化使得理论上的 5 倍压缩真正转化为端到端的推理加速,在 256k 的超长序列下,单算子甚至能实现最高 9 倍的加速。

结语

RTPurbo 的成功不仅仅是阿里 Qwen 系列模型的胜利,它为整个 LLM 行业提供了一个清晰的信号:长文本推理的高成本并非不可逾越。通过更精细的可解释性分析和工程优化,我们完全可以在保留模型“智慧”的同时,大幅“瘦身”其计算开销。

随着类似 RTPurbo 技术的普及,未来的 AI 应用将不再受限于上下文窗口的计费压力,真正的“吞书”级应用将变得触手可及。想要了解更多关于 OpenAI、ChatGPT 以及前沿 AI新闻 的深度解析,请持续关注 AIGC.BAR,这里是您获取高质量 AI资讯 的首选 AI门户。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)