ICLR泄露门深度复盘:21%审稿由AI生成,学术圈信任崩塌

type

status

date

slug

summary

tags

category

icon

password

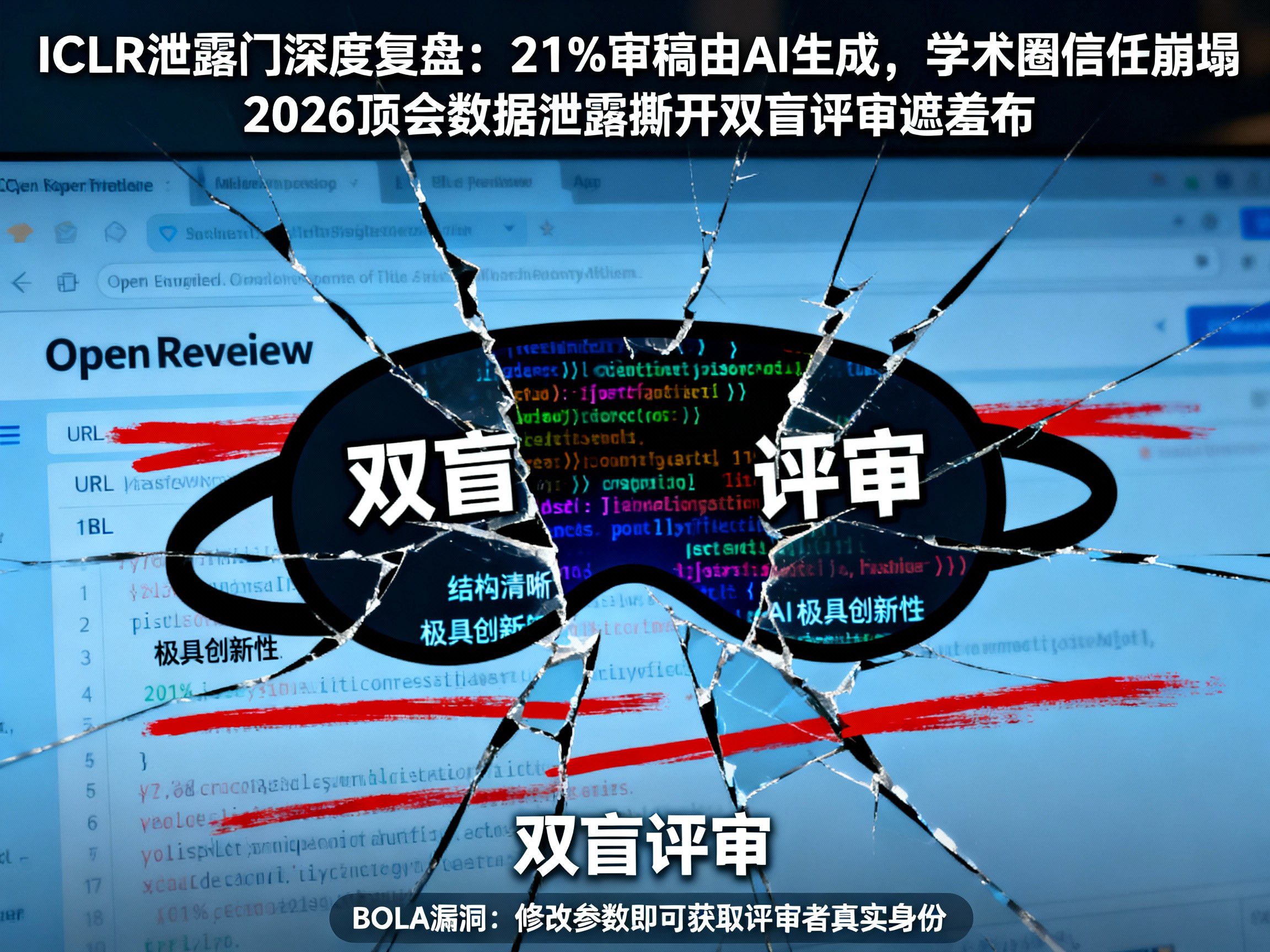

网址

2025年的感恩节,注定将被载入人工智能发展的史册,但并非因为某项突破性的AGI技术,而是因为一场荒诞至极的“裸奔”闹剧。全球顶会ICLR 2026爆发了前所未有的数据泄露事件,不仅撕开了双盲评审的遮羞布,更通过后续的数据分析,向世界展示了一个令人啼笑皆非的真相:在一个致力于研究人工智能的顶级会议中,竟然有超过五分之一的裁判是AI本身。

这一事件不仅重创了学术界的公信力,更让我们被迫直视大模型(LLM)时代下科研生态的异化。从“人肉搜索”审稿人到“AI互吹”,这疯狂的61分钟究竟揭示了什么?

低级漏洞引发的蝴蝶效应

故事的起因简单得令人发指。承载着ICLR、NeurIPS等顶会评审工作的OpenReview平台,犯了一个大一新生都不应该犯的错误——BOLA(对象级授权失效)漏洞。这并非高深的黑客攻防,只需修改URL中的参数,任何人都可以在那一小时内,轻易获取投稿论文作者、审稿人乃至领域主席(AC)的真实身份。

这就好比你去住酒店,发现只要把房卡上的房间号涂改一下,就能刷开整栋楼的房门。这种技术上的低级失误,瞬间引发了学术圈的“开盒”狂欢。原本神圣的“双盲评审”机制,在这一刻彻底失效。ICLR瞬间被戏称为“I Can Locate Reviewer”(我能定位审稿人),愤怒、恐慌与报复心理在社交媒体上交织。

黑暗森林法则:从学术交流到利益交换

如果说技术漏洞是可以修复的,那么此次事件暴露的人性弱点则是无法修补的。在数据泄露后的短短24小时内,学术界仿佛瞬间退化到了“黑暗森林”状态:

- 人肉与报复:有了真实名单,那些给出差评的审稿人立刻成为了靶子。有的被竞争对手“定点清除”,有的则面临被挂在网上“公开处刑”的风险。

- 贿赂与串通:更可怕的是,利益链条迅速浮出水面。原本隐秘的“审稿人圈子”被实锤,通过邮件直接联系、甚至金钱贿赂来换取高分的行为不再是传说。

这不仅仅是学术不端,更是对科研精神的毁灭性打击。然而,在这场人性的闹剧中,一家名为Pangram Labs的公司却发现了比“人肉”更荒诞的真相。

21%的僵尸评审:AI写,AI审,AI信

利用泄露的数据,Pangram Labs对ICLR 2026的75,800条评审意见进行了AI内容检测,结果令人咋舌:21%的审稿意见完全由AI生成,超过50%的意见有AI润色痕迹。

这描绘出了一幅极其赛博朋克的画面:

1. 作者利用ChatGPT或Claude等工具辅助甚至代写论文。

2. 审稿人面对海量投稿,直接将PDF丢给大模型,输入Prompt生成评审意见。

3. OpenReview的算法将这些由AI生成的意见分发回去。

人类在这个闭环中,仿佛变成了一个单纯负责复制粘贴的“中间商”。这些AI生成的意见往往充满了漂亮的废话:“结构清晰”、“极具创新性”,却指不出任何实质性逻辑漏洞,甚至会出现“幻觉引用”,一本正经地胡说八道。

对于关注AI资讯和LLM发展的读者来说,这无疑是一个巨大的讽刺:我们创造了AI来辅助科研,结果AI却在用虚假的数据和评价体系,污染着人类最高的智慧殿堂。这直接导致了学术评价体系的通货膨胀和失效。

系统性崩溃背后的原因:算力与产能的错配

为什么会有这么多审稿人选择用AI作弊?除了个人道德问题,更深层的原因在于现有的同行评审制度已经无法承载人工智能领域的爆发式增长。

从ICLR 2024的7000篇投稿,到2026年的近20000篇,论文数量呈指数级增长,但合格的人类审稿人(通常是博士生、教授)数量并没有同步增加。在“Publish or Perish”(不发表就出局)的高压下,审稿变成了一种无偿且繁重的苦役。当每个人都要在两周内读完8篇晦涩难懂的论文时,大模型工具就成了难以抗拒的诱惑。

这种产能过剩与审核算力不足的矛盾,正在逼迫学术界寻找新的出路。如果无法解决这个问题,未来的顶会可能真的会变成由OpenAI的模型写论文,再由Google的模型来审稿的“无人区”。

结语:重建信任的漫长之路

ICLR此次采取了“核按钮”式的补救措施:重置分数、更换AC、封杀违规者。这虽然暂时止住了血,但无法挽回已经崩塌的信任。

这次“泄露门”或许是件好事,它以一种极端的方式刺破了泡沫。它提醒我们,在AGI和人工智能飞速发展的今天,我们不仅需要关注技术的突破,更需要关注如何建立一个适应AI时代的、真实可信的学术评价体系。否则,我们引以为傲的科学大厦,可能不仅地基是歪的,甚至连砖块都是AI幻觉生成的泡沫。

想要了解更多关于此次事件的后续发展,以及最新的AI新闻、大模型动态和AI变现趋势,请持续关注专业的AI门户:AIGC.BAR,获取最前沿的AI日报和深度解读。

Loading...

.png?table=collection&id=1e16e373-c263-81c6-a9df-000bd9c77bef&t=1e16e373-c263-81c6-a9df-000bd9c77bef)